¿Por qué hablar en inglés a los LLMs? La realidad técnica detrás del consejo más repetido en IA

29 de septiembre de 2025

El consejo que todos hemos escuchado

"Si quieres mejores resultados, háblale en inglés". Es el consejo no oficial que circula en cada foro de IA, cada tutorial de ChatGPT y cada conversación entre desarrolladores. Lo hemos normalizado tanto que muchos profesionales hispanohablantes han adoptado el inglés como su lengua por defecto para interactuar con modelos de lenguaje, incluso cuando van a generar contenido en español.

Pero ¿de dónde viene realmente esta recomendación? ¿Es solo un mito urbano de la comunidad tech, o hay razones técnicas reales detrás? Y más importante: ¿cuál es el verdadero costo de seguir este consejo?

La anatomía del problema: ¿Qué son los tokenizadores?

El proceso invisible que determina todo

Para entender por qué el español tiene desventajas técnicas en los LLMs, necesitamos adentrarnos en uno de los componentes más críticos y menos comprendidos de estos sistemas: los tokenizadores. Si los LLMs son el cerebro de la IA, los tokenizadores son el sistema nervioso que convierte nuestras palabras en impulsos que el modelo puede procesar.

Imagina que un LLM es como un chef extraordinario, pero que solo puede cocinar con ingredientes que vienen en porciones pre-cortadas específicas. El tokenizador es el sous chef que debe cortar todos los ingredientes (nuestro texto) en esas porciones exactas antes de que el chef principal pueda trabajar. La forma en que se cortan estos ingredientes determinará la calidad final del plato.

Cómo un LLM "lee" realmente tu texto

Cuando escribes "La inteligencia artificial está revolucionando el mundo", esto es lo que sucede bajo el capó:

Paso 1: Tokenización

Texto original: "La inteligencia artificial está revolucionando el mundo"

Tokens en GPT-4:

10 tokens total

10 tokens total

Para comparar, la misma idea en inglés:

Texto original: "Artificial intelligence is revolutionizing the world"

Tokens en GPT-4:

8 tokens total

8 tokens total

¿Notas la diferencia? La frase en español requiere 25% más tokens para expresar la misma idea. Y esto es solo un ejemplo simple.

El sesgo histórico que nos afecta hoy

Los tokenizadores de los LLMs más populares fueron diseñados usando una técnica llamada Byte Pair Encoding (BPE), entrenada principalmente sobre corpus de texto en inglés. Este proceso identifica las combinaciones de caracteres más frecuentes y las convierte en tokens únicos.

El problema fundamental: Como el inglés dominó los datos de entrenamiento, las combinaciones más comunes son inherentemente anglocéntricas:

- "ing" → token único (aparece constantemente en inglés)

- "tion" → token único (súper común en inglés)

- "ando" → dividido en múltiples tokens (menos frecuente en los datos)

- "ción" → dividido en múltiples tokens (español infrarrepresentado)

Un ejemplo revelador: palabras técnicas

Veamos qué sucede con vocabulario técnico, especialmente relevante para profesionales:

Palabra: "desarrollador"

Tokenización GPT-4:

4 tokens

4 tokens

Palabra: "developer"

Tokenización GPT-4:

1 token

1 token

Resultado: La palabra española necesita 4x más tokens que su equivalente inglés. Esto no es casualidad, es el resultado directo del sesgo en los datos de entrenamiento del tokenizador.

Más allá de las palabras individuales: el efecto compuesto

El problema se amplifica cuando consideramos textos completos. Analicemos un párrafo técnico típico:

Texto en español (44 palabras):

"Nuestro equipo de desarrolladores está implementando una arquitectura de microservicios basada en contenedores para mejorar la escalabilidad y mantenibilidad del sistema. La infraestructura utiliza tecnologías de orquestación avanzadas que permiten el despliegue automatizado y la monitorización en tiempo real de todos los componentes distribuidos."

Tokenización (GPT-4o): 62 tokens

Equivalente en inglés (32 palabras):

"Our development team is implementing a container-based microservices architecture to improve system scalability and maintainability. The infrastructure uses advanced orchestration technologies that enable automated deployment and real-time monitoring of all distributed components."

Tokenización (GPT-4o): 39 tokens

Diferencia real: El texto en español requiere 58.9% más tokens para expresar el mismo concepto técnico.

Los números que importan: Cuatro impactos reales de la fragmentación

Por qué esto importa más de lo que piensas

Hemos visto cómo "desarrollador" se convierte en cuatro fragmentos mientras "developer" permanece entero, y cómo un párrafo técnico en español necesita 58.9% más tokens. Pero estos números no son solo curiosidades académicas. La fragmentación del español tiene cuatro impactos directos y medibles en tu experiencia real con LLMs.

1. Costo por interacción: cada token fragmentado sale de tu bolsillo

La realidad más inmediata es económica: pagas por cada token procesado, y el español genera sistemáticamente más tokens para expresar las mismas ideas.

Tomemos el ejemplo real del párrafo sobre microservicios que analizamos anteriormente. En español consume 62 tokens, en inglés apenas 39. Si usas GPT-4 a $30 por millón de tokens, cada vez que generas esa explicación técnica estás pagando $0.00186 en español versus $0.00117 en inglés. Una diferencia de $0.00069 por consulta.

¿Parece insignificante? Multiplica por 10,000 consultas mensuales típicas de una aplicación mediana, y esa diferencia se convierte en $6.90 mensuales, o $82.80 anuales. No es que vayas a quebrar, pero estás pagando un impuesto del 58.9% por usar tu idioma nativo.

El ejemplo extremo lo vimos con "desarrollador" (4 tokens) versus "developer" (1 token). Si tu aplicación genera frecuentemente terminología técnica, estás pagando cuatro veces más por palabras que deberían costar lo mismo.

2. Límite de contexto: perdiendo espacio mental valioso

Los LLMs tienen una "ventana de atención" limitada: solo pueden procesar cierta cantidad de tokens simultáneamente. GPT-4 puede manejar hasta 128,000 tokens de contexto, pero cada token español desperdiciado es espacio que no puedes usar para información útil.

Volvamos al ejemplo de "desarrollador" fragmentado en 4 tokens. En un documento técnico típico con 50 términos especializados similares:

-

Versión española: 50 términos × 4 tokens promedio = 200 tokens solo en vocabulario

-

Versión inglesa: 50 términos × 1 token promedio = 50 tokens

Resultado: 150 tokens desperdiciados que podrían haberse usado para más contexto, más ejemplos, o instrucciones más detalladas.

Si estás trabajando cerca del límite de contexto de un modelo (digamos, 4,000 tokens para un caso práctico), la versión española puede procesar efectivamente 3,800 tokens de contenido real, mientras que la inglesa aprovecha 3,950 tokens. Pierdes 150 tokens de capacidad útil, que representa un 3.8% menos de información procesable para el mismo límite de contexto.

3. Velocidad de procesamiento: más tokens equivale a más tiempo de espera

Cada token adicional requiere cómputo adicional. No es una relación perfectamente lineal, pero existe una correlación clara: más tokens = más tiempo de procesamiento.

Usando nuestro ejemplo del párrafo técnico (62 tokens español vs 39 inglés), si una consulta en inglés se procesa en 800 milisegundos, la versión española necesitará aproximadamente:

800ms × (62 ÷ 39) = 1,272ms

Una diferencia de 472 milisegundos que los usuarios perciben como lentitud. En una conversación interactiva, esta latencia adicional rompe el flujo natural del diálogo.

Escala esto a una aplicación que procesa 100 consultas por hora durante 16 horas diarias (1,600 consultas), y estás invirtiendo 12.6 minutos adicionales diarios solo en procesar la ineficiencia del tokenizador español.

4. Calidad de atención: el modelo debe trabajar más duro para entenderte

Este es quizás el impacto más sutil pero importante. Cuando "desarrollador" se fragmenta en ["desarr", "oll", "ador"], el modelo debe reconstruir el significado completo a partir de fragmentos que individualmente pueden tener múltiples interpretaciones.

Piénsalo como una conversación donde cada palabra técnica te llega dividida en sílabas separadas, con ruido entre medio. Tu cerebro debe trabajar extra para reconstruir el significado. Los LLMs enfrentan el mismo desafío: deben dedicar recursos de atención adicionales para entender qué querías decir realmente.

La consecuencia práctica es que el modelo tiene menos "capacidad mental" disponible para la tarea real. En lugar de concentrarse completamente en generar la mejor respuesta, debe dedicar parte de su atención a resolver rompecabezas lingüísticos causados por la fragmentación.

Esta pérdida de calidad de atención puede manifestarse en respuestas menos precisas, razonamiento menos profundo, o simplemente una sensación de que el modelo "no te entiende tan bien" en español.

El efecto compuesto: cuando los cuatro impactos se combinan

Lo más problemático no es ninguno de estos factores por separado, sino cómo se amplifican mutuamente. Pagas más por tokens menos eficientes, que consumen más espacio de contexto, que requieren más tiempo de procesamiento, mientras el modelo lucha por mantener la misma calidad de atención.

El resultado es una degradación sistémica de la experiencia que va más allá del simple costo económico. Tu interacción con el LLM se vuelve objetivamente menos eficiente en español, no por limitaciones del idioma en sí, sino por decisiones técnicas tomadas durante el desarrollo de estos sistemas.

¿Significa esto que deberías abandonar el español?

No necesariamente. Estos cuatro impactos son hechos técnicos medibles, pero la decisión de qué idioma usar debe incluir factores que van más allá de la eficiencia pura: la naturalidad de la respuesta para tu audiencia, la precisión cultural del contenido, y el valor de mantener tu identidad lingüística.

La clave está en entender los costos reales para tomar decisiones informadas, no en aceptar consejos genéricos sobre usar inglés "porque es mejor". Ahora sabes exactamente por qué el inglés puede ser más eficiente, y puedes decidir si esa eficiencia vale más que los beneficios de operar en tu idioma nativo.

Nuestras últimas novedades

¿Te interesa saber cómo nos adaptamos constantemente a la nueva frontera digital?

Insight

3 de marzo de 2026

Agentes de IA y gobierno del dato: la base del nuevo ciclo tecnológico

Insight

2 de marzo de 2026

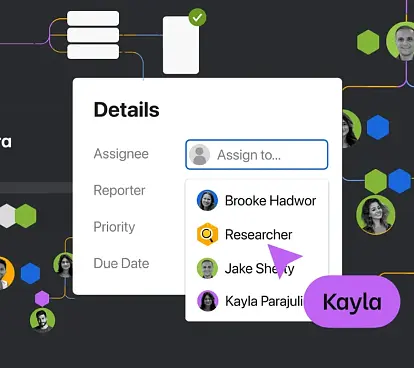

Ya puedes asignar tareas de Jira a tus agentes Rovo

Corporate news

17 de febrero de 2026

Consiguiendo la entrega correcta a la primera: por qué Chris Brown se unió a Sngular para ayudar a las organizaciones estadounidenses a convertir la IA en resultados

Insight

12 de febrero de 2026

Escalando la IA sin perder el control